С каждым годом поиск в интернете становится качественнее, ведь поисковые системы работают «не покладая рук» над улучшением релевантности выдачи. И именно борьба за пользователей стимулирует этот процесс. Как поисковым машинам удалось существенно улучшить ранжирование?

Всё дело в регулярно обновляющихся алгоритмах. Фильтры призваны отсеивать некачественный контент и давать пользователям самую точную и отборную информацию. Некоторые из них направлены на выявление уровня качества материалов, ведь в интернете всё ещё много устаревшего, низкосортного и даже опасного для пользователя текстового контента. Алгоритмы «математические формулы» призваны максимально качественно улучшить поисковую выдачу.

Давайте рассмотрим алгоритмы Google и Яндекс, которые борются с плохим контентом. Это полезно владельцам сайтов, которые делают ставку на текстовое продвижение своего бизнеса.

Алгоритмы Google, для которых важно качество контента

Условно их можно разделить на такие группы:

Условно их можно разделить на такие группы:

1. Против скрытого текста

Сюда входят Cassandra, Florida, Austin и другие. Их цель – выявить сайты с материалами, которые невидимы для пользователей, но индексируются поисковыми роботами. Если вы используете серые/чёрные методы SEO, например, выбор нулевого шрифта, скрытый редирект или поисковый спам, будьте готовы к тому, что ваш сайт рано (более вероятно) или поздно перестанет индексироваться и исчезнет из поисковой выдачи.

2. Против неуникальности и плагиата

Яркий представитель этой группы фильтров – знаменитый Panda от Google. Он запущен в 2011 году и с тех пор вышло несколько его значительных обновлений. Панда наказывает сайты за размещение чужих текстов, а также за дублирование одного и того же материала на нескольких страницах. Согласно статистике Google, в год своего запуска этот алгоритм затронул 12% ресурсов, контент которых оставлял желать лучшего.

Самая крупная поисковая система борется также с нарушением авторских прав в интернете. Для этого в 2012-м году введён алгоритм DMCA Penalty (Pirate).

3. Против переспама и некачественного внедрения ключевых слов

Несколько крупных алгоритмов ежедневно исключают из выдачи сайты, контент которых перегружен ключевыми запросами. Среди них:

– Florida. Это одна из самых ранних разработок компании Google, благодаря которой многие ресурсы отказались от использования сомнительных методов SEO. После её введения сайты с обилием ключевых фраз, неуникальными текстами и покупными ссылками, стали ранжироваться намного хуже или были вовсе исключены из выдачи.

– Panda. Он тоже борется со злоупотреблением ключевыми словами в текстах. А ещё отслеживает плохой пользовательский опыт (поведение посетителей, в том числе процент отказов), несоответствие мета-тегов содержанию страницы.

– Panda. Он тоже борется со злоупотреблением ключевыми словами в текстах. А ещё отслеживает плохой пользовательский опыт (поведение посетителей, в том числе процент отказов), несоответствие мета-тегов содержанию страницы.

– Pinguin. В основном он направлен на борьбу с покупными ссылками, но если на страницах вашего сайта есть неестественные анкоры, может повлиять и на него. В поле зрения алгоритма также заспамленные ресурсы.

– Hummingbird. Благодаря ему поиск стал более «человечным», ведь роботы научились определять смысл страницы по синонимам ключевого слова. Он исключает из выдачи контент с неестественным вхождением ключевых фраз.

– RankBrain. Его цель – предоставлять пользователям максимально релевантные результаты поиска. Он принимает во внимание поведение посетителей страницы, их опыт, время чтения, процент отказов и т. д. Алгоритм анализирует не только ключевые слова, но и контекст. Согласно сведениям Google, каждый день он обрабатывает 15% всех запросов и миллиарды страниц.

– Fred. Исключает из индекса сайты с обилием рекламы и исходящих ссылок. Беспощаден к ресурсам, на которых размещены статьи «для роботов» с исключительной целью генерации трафика.

– Page Layout algorithm. Выпущен в 2012-м году в результате жалоб пользователей на обилие рекламы вверху страниц. Из-за этого людям приходится прокручивать их вниз, чтобы получить доступ к нужному материалу.

4. Против неактуальных и устаревших публикаций

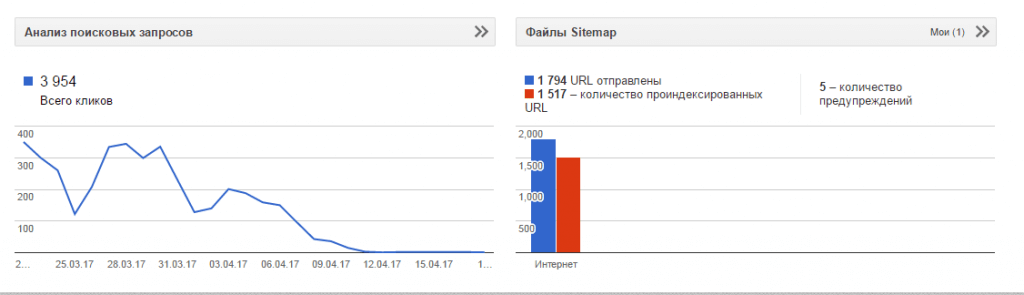

В 2015-м году заработал алгоритм Freshness, из-за которого в выдачу не попадают устаревшие сайты. Он определяет актуальность контента на страницах в зависимости от тематики и сферы деятельности ресурса. Если на сайте не появляется новый контент и не создаются новые страницы, со временем он перестаёт индексироваться и вы можете получить похожую картину индексирования:

Органический трафик с Google.

Это основные группы алгоритмов Google, которые следят за качеством контента на сайтах. Некоторые из них, например, Панда, принимают во внимание различные ошибки в текстах, удобство чтения, HTML-разметку, длину материалов. Для ранжирования сайта немаловажны и отзывы пользователей о нём, особенно если это онлайн-магазин.

Действия «Яндекса», направленные на борьбу с плохим контентом

В целом, поисковая система Яндекс борется с теми же проблемами наполнения сайтов, что и Google: скрытые и бессмысленные тексты, переспам, копипаст, переоптимизация и т. д. Один из самых ярких алгоритмов Яндекса, которые касаются контента – «Баден-Баден».

Он заработал в марте 2017-го и серьёзно ужесточил ранжирование некоторых ресурсов. Понижает в выдаче сайты, содержащие обилие ключевых фраз в подзаголовках и теле текстов. Поисковая система различает синонимы основного запроса, поэтому лучше избегать частого употребления основных ключей. Алгоритм выявляет:

– чрезмерно большие тексты, перенасыщенные ключами;

– материалы любой длины с частым использованием ключевых запросов;

– неотформатированные статьи (без деления на смысловые блоки, иллюстраций и списков).

Если сайт нарушает правила поисковой системы, то он рано или поздно сталкивается с фильтрами. Следите за тем, чтобы информация в ваших сниппетах была понятной и уникальной, а сайт не содержал чужие тексты, назойливую рекламу, накрученную ссылочную массу. Если ресурс приносит пользу людям и следует правилам поисковой системы, исключение из поисковой выдачи ему не грозит.

1 ответ